Cinco avances de la GPU Nvidia A100

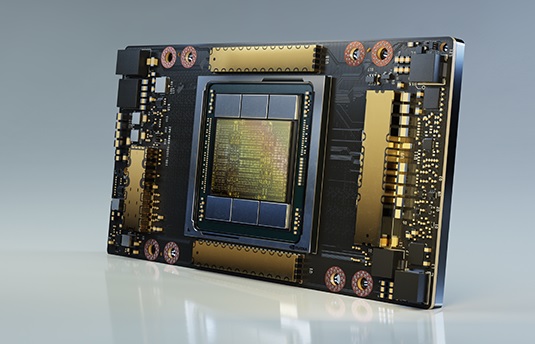

El fabricante anunció que la primera GPU basada en su arquitectura de Ampere, Nvidia A100, se está fabricando y enviando a los clientes de todo el mundo.

La A100 se presenta como la de mayor rendimiento de la compañía hasta la fecha dentro de sus ocho generaciones de GPUs. Es un acelerador de carga de trabajo universal, que también está diseñado para el análisis de datos, la computación científica y los gráficos en la nube, especificó la marca.

La A100 se presenta como la de mayor rendimiento de la compañía hasta la fecha dentro de sus ocho generaciones de GPUs. Es un acelerador de carga de trabajo universal, que también está diseñado para el análisis de datos, la computación científica y los gráficos en la nube, especificó la marca.

«Las tendencias de la computación en la nube y la IA están impulsando un cambio tectónico en los diseños de los centros de datos, de modo que lo que una vez fue un mar de servidores sólo de CPUs, ahora es la computación acelerada por el GPU», dijo Jensen Huang, fundador y CEO de Nvidia. “La GPU A100 es un salto cuántico en el rendimiento de IA de 20 veces y un acelerador del aprendizaje automático de principio a fin, desde el análisis de datos hasta la capacitación y la inferencia. Por primera vez, las cargas de trabajo de ampliación y escalabilidad pueden acelerarse en una sola plataforma. A100 aumentará simultáneamente el rendimiento y reducirá el costo de los centros de datos», afirmó el directivo.

Las tecnologías elásticas de cómputo integradas en A100 permiten aportar la cantidad adecuada de potencia de procesamiento a cada trabajo. La capacidad de GPU de múltiples instancias permite que cada GPU A100 se divida en hasta siete instancias independientes de «mini-GPUs» para realizar tareas de inferencia más pequeñas, mientras que la tecnología de interconexión NVLink interconnect technology de tercera generación, permite que múltiples GPUs A100 funcionen como una GPU gigante, para cumplir con las tareas de entrenamiento cada vez más grandes, detalló el fabricante.

Agregó que los principales fabricantes de sistemas y proveedores de servicios en la nube del mundo, que planean incorporar las GPUs A100 a sus ofertas de productos y servicios de HPC, Ciencia de Datos e IA son: Alibaba Cloud, Amazon Web Services (AWS), Atos, Baidu Cloud, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Google Cloud, H3C, Hewlett Packard Enterprise (HPE), Inspur, Lenovo, Microsoft Azure, Oracle, Quanta/QCT, Supermicro and Tencent Cloud.

Cinco avances de A100

–Arquitectura Ampere, que contiene más de 54,000 millones de transistores, lo que la hace el procesador de 7 nanómetros más grande del mundo.

—Third-generation Tensor Cores with TF32: Los núcleos Tensor de amplia adopción de ahora son más flexibles, rápidos y fáciles de usar. Sus capacidades expandidas incluyen nuevos TF32 for AI, que permiten un rendimiento de IA de hasta 20 veces mayor, con precisión FP32, sin cambiar el código. Además, los núcleos Tensor ahora permiten FP64, para lograr hasta 2.5 veces más de procesamiento de datos que la generación anterior, para las aplicaciones de HPC.

—GPU de múltiples instancias: MIG, una nueva función técnica, que permite que una sola GPU A100 se particione en hasta siete GPUs por separado, para poder proporcionar diferentes grados de procesamiento para trabajos de diferentes tamaños, lo que permite una utilización óptima y el máximo retorno de la inversión.

—Third-generation NVLink: Duplica la conectividad de alta velocidad entre las GPUs para proporcionar escalabilidad de rendimiento eficiente en un servidor.

—Baja densidad estructural: Esta nueva técnica aprovecha la naturaleza ineherentemente escasa de los cálculos de IA para duplicar el rendimiento.

Según la marca, estas nuevas características hacen que la A100 sea ideal para cargas de trabajo diversas y exigentes, que incluyen entrenamiento e inferencia de IA, así como simulación científica, IA conversacional, sistemas de recomendación, genómica, análisis de datos de alto rendimiento, modelos sísmicos y pronósticos financieros.

Asimismo mencionó que el modelo A100 está disponible en nuevos sistemas, y pronto llegará a la nube.